Tout savoir sur le webscrapping en python

- Auteur

-

Franck Mairot

- Publié le

- Partager

Le web scraping est une technique puissante qui permet d’extraire automatiquement des données à partir de sites web. En maîtrisant les principes fondamentaux du web scraping avec Python et en utilisant les bibliothèques dédiées, vous serez en mesure de collecter efficacement des informations précieuses pour vos projets d’analyse ou de machine learning. Découvrez dans cet article comment exploiter tout le potentiel du web scraping de manière éthique et responsable.

Définition et objectifs du web scraping

Le web scraping est une technique qui consiste à extraire automatiquement des données à partir de sites web. Son objectif principal est de collecter des informations de manière efficace et rapide, en évitant le fastidieux processus de copier-coller manuel. Grâce au web scraping, il est possible de récupérer en quelques minutes des volumes importants de données, qui peuvent ensuite être analysées et exploitées pour diverses finalités.

Certains sites web interdisent explicitement aux utilisateurs de récupérer leurs données à l’aide d’outils automatisés tels que ceux que vous allez créer dans ce tutoriel. Les sites web agissent de la sorte pour deux raisons possibles :

- Le site a une bonne raison de protéger ses données. Par exemple, Google Maps ne vous permet pas de demander trop de résultats trop rapidement.

- L’envoi répété de nombreuses requêtes au serveur d’un site web peut utiliser la bande passante, ralentir le site web pour les autres utilisateurs et éventuellement surcharger le serveur au point que le site web ne réponde plus du tout.

Avant d’utiliser vos compétences en Python pour faire du web scraping, vous devez toujours vérifier la politique d’utilisation acceptable du site web cible pour voir si l’accès au site web avec des outils automatisés constitue une violation de ses conditions d’utilisation. D’un point de vue juridique, le web scraping contre la volonté d’un site web est une zone grise.

Important : sachez que les techniques suivantes peuvent être illégales lorsqu’elles sont utilisées sur des sites web qui interdisent le web scraping.

Avantages du langage Python pour le web scraping

| Avantages de Python | Description |

|---|---|

| Simplicité | Syntaxe claire et concise, facilitant la prise en main |

| Bibliothèques dédiées | Large gamme d’outils comme Requests, BeautifulSoup, Scrapy |

| Flexibilité | Possibilité de s’adapter aux spécificités de chaque site web |

| Performance | Création rapide de scripts solides et efficaces |

Python est souvent considéré comme le langage de prédilection pour le web scraping, et ce pour plusieurs raisons.

Tout d’abord, sa syntaxe claire et concise facilite la prise en main, même pour les développeurs novices.

De plus, Python dispose d’une large gamme de bibliothèques dédiées au web scraping, telles que Requests, BeautifulSoup ou Scrapy, qui simplifient grandement le processus d’extraction de données.

Les différentes librairies de Web scraping en python

L’un des avantages de Python est qu’il offre un grand choix de bibliothèques pour le web scraping. Ces bibliothèques font partie de milliers de projets Python existants – rien que sur PyPI, il y a plus de 300 000 projets aujourd’hui. Il existe notamment plusieurs types de bibliothèques de web scraping Python parmi lesquelles vous pouvez choisir :

- Requests

- Beautiful Soup

- lxml

- Selenium

La bibliothèque Requests

Le web scraping commence par l’envoi de requêtes HTTP, telles que POST ou GET, au serveur d’un site web, qui renvoie une réponse contenant les données nécessaires. Cependant, les bibliothèques HTTP Python standard sont difficiles à utiliser et, pour être efficaces, nécessitent des lignes de code volumineuses, ce qui aggrave encore une situation déjà problématique.

python3 -m pip install requests

La bibliothèque des requêtes fournit des méthodes simples pour envoyer des requêtes HTTP GET et POST Par exemple, la fonction permettant d’envoyer une requête HTTP GET est judicieusement nommée get() :

import requests

response = requests.get('https://brends.co/')

print(response.text)

S’il est nécessaire de poster un formulaire, cela peut être fait facilement en utilisant la méthode post(). Les données du formulaire peuvent être envoyées sous la forme d’un dictionnaire comme suit :

form_data = {'key1': 'value1', 'key2': 'value2'} response = requests.post('https://httpbin.org/post', data=form_data) print(response.text)

La bibliothèque Beautiful Soup

Beautiful Soup est une bibliothèque Python qui fonctionne avec un analyseur pour extraire des données de HTML et peut transformer même un balisage invalide en un arbre d’analyse. Cependant, cette bibliothèque n’est conçue que pour l’analyse syntaxique et ne peut pas demander des données à des serveurs web sous la forme de documents/fichiers HTML. Pour cette raison, elle est principalement utilisée avec la bibliothèque Python Requests. Notez que Beautiful Soup facilite l’interrogation et la navigation dans le HTML, mais nécessite toujours un analyseur. L’exemple suivant démontre l’utilisation du module html.parser, qui fait partie de la bibliothèque standard de Python. Installez la bibliothèque en ouvrant votre terminal et en exécutant cette ligne :

pip install beautifulsoup4Partie 1 – Obtenir le code HTML à l’aide de Requests

import requests

url = 'https://brends.co/blog'

response = requests.get(url)Partie 2 – Trouver l’élément

import requests

from bs4 import BeautifulSoup

url = 'https://brends.co/blog'

response = requests.get(url)

soup = BeautifulSoup(response.text, 'html.parser')

print(soup.title)L’élément de titre sera imprimé comme suit :

<title>Blog - Brends</title>Grâce à ses méthodes simples de navigation, de recherche et de modification de l’arbre d’analyse, Beautiful Soup est idéal même pour les débutants et permet généralement aux développeurs d’économiser des heures de travail. Par exemple, pour imprimer tous les titres de blogs de cette page, la méthode find_all() peut être utilisée.

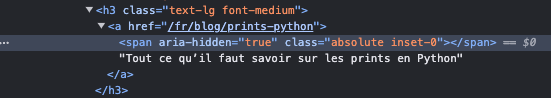

Il se peut que vous deviez utiliser les Developer Tools, une fonction intégrée aux navigateurs web qui vous permet de visualiser le code HTML de la page et offre d’autres fonctionnalités aux développeurs web. Ouvrez les outils de développement en vous rendant dans les paramètres du navigateur ou en utilisant un raccourci clavier : sous Windows, appuyez sur F12 ou Shift + Ctrl + I, et sous macOS, appuyez sur Option + ⌘ + I.

Appuyez ensuite sur le bouton du sélecteur d’éléments, qui se trouve dans le coin supérieur gauche des outils de développement. Vous pouvez également appuyer sur les touches Maj + Ctrl + C sous Windows et Maj + ⌘ + C sous macOS :

En regardant cet extrait, vous pouvez voir que le titre de l’article de blog est stocké dans la balise avec une classe d’attribut définie sur “absolute” et “inset-0”.

En regardant plus loin, vous devriez voir que tous les autres titres sont stockés exactement de la même manière. Comme il n’y a pas d’autres éléments avec les mêmes valeurs de classe dans tout le document HTML, vous pouvez utiliser la valeur “text-lg” pour sélectionner tous les éléments qui stockent les titres des blogs. Ces informations peuvent être fournies à la fonction find_all comme suit :

blog_titles = soup.find_all('a', class_='inset-0')

for title in blog_titles:

print(title.text)

# Output:

# Prints all blog tiles on the pageNotez que vous devez définir la classe en utilisant le mot-clé class_ (avec un trait de soulignement). Sinon, vous recevrez une erreur.

Vous pouvez également utiliser des expressions régulières (regex) dans la méthode find_all(). Par exemple, le code ci-dessous récupère tous les titres des articles de blog, comme indiqué précédemment :

import re

# Send a request and pass the response to Beautiful Soup just like before

blog_titles = soup.find_all('a', class_=re.compile('inset-0'))

for title in blog_titles:

print(title.text)

C’est très utile lorsque vous avez besoin d’une méthode plus souple et plus précise pour trouver des éléments.

BeautifulSoup facilite également le travail avec les sélecteurs CSS. Si un développeur connaît un sélecteur CSS, il n’a pas besoin d’apprendre les méthodes find() ou find_all(). L’exemple suivant utilise la méthode soup.select :

blog_titles = soup.select('a.inset-0')

for title in blog_titles:

print(title.text)Bien que l’analyse HTML cassée soit l’une des principales caractéristiques de cette bibliothèque, elle offre également de nombreuses fonctions, notamment le fait qu’elle peut détecter le codage des pages, ce qui augmente encore la précision des données extraites du fichier HTML.

De plus, avec seulement quelques lignes de code, elle peut être facilement configurée pour extraire n’importe quelle donnée publique personnalisée ou identifier des types de données spécifiques.

Lxml

lxml est une bibliothèque d’analyse rapide, puissante et facile à utiliser qui fonctionne avec les fichiers HTML et XML. En outre, lxml est idéale pour extraire des données à partir de grands ensembles de données. Cependant, contrairement à Beautiful Soup, cette bibliothèque est affectée par un HTML mal conçu, ce qui entrave ses capacités d’analyse.

La bibliothèque lxml peut être installée depuis le terminal à l’aide de la commande pip :

pip install lxmlCette bibliothèque contient un module html pour travailler avec le HTML. Cependant, la bibliothèque lxml a d’abord besoin de la chaîne HTML. Cette chaîne HTML peut être récupérée à l’aide de la bibliothèque requests, comme nous l’avons vu dans la section précédente. Une fois le HTML disponible, l’arbre peut être construit en utilisant la méthode fromstring comme suit :

import requests

from lxml import html

url = 'https://brends.co/blog'

response = requests.get(url)

tree = html.fromstring(response.text)

Cet objet arbre peut maintenant être interrogé à l’aide de XPath. En reprenant l’exemple de la section précédente, l’expression XPath permettant d’obtenir les titres des blogs serait la suivante :

//a[contains(@class, "text-lg")]La fonction contains() ne sélectionne que les éléments dont la valeur de classe est text-lg. Ce XPath peut être donné à la fonction tree.xpath(). Celle-ci renverra tous les éléments correspondant à ce XPath :

blog_titles = tree.xpath('/html/body/div[2]/main/section/article[3]/div[2]/h3/span/')

for title in blog_titles:

print(title.text)Si vous souhaitiez apprendre à utiliser cette bibliothèque et à l’intégrer dans vos efforts de scraping web ou même acquérir plus de connaissances en plus de votre expertise existante. Dans ce cas, notre tutoriel lxml détaillé est un excellent point de départ.

Sélénium

Comme nous l’avons dit, certains sites web sont écrits en JavaScript, un langage qui permet aux développeurs de remplir les champs et les menus de manière dynamique. Cela pose un problème pour les bibliothèques Python qui ne peuvent récupérer des données qu’à partir de pages web statiques. En fait, comme nous l’avons dit, la bibliothèque Requests n’est pas une option lorsqu’il s’agit de JavaScript. C’est là que le scraping web Selenium entre en jeu et prospère.

Cette bibliothèque web Python est un outil d’automatisation de navigateur (pilote web) open-source qui vous permet d’automatiser des processus tels que la connexion à une plateforme de médias sociaux. Selenium est largement utilisé pour l’exécution de cas de test ou de scripts de test sur des applications web. Sa force dans le cadre du web scraping provient de sa capacité à initier le rendu de pages web, tout comme n’importe quel navigateur, en exécutant JavaScript – les web crawlers standards ne peuvent pas exécuter ce langage de programmation. Pourtant, il est aujourd’hui largement utilisé par les développeurs. De plus, Selenium peut aider à contourner les tests CAPTCHA puisque les requêtes web sont effectuées par le biais d’un véritable navigateur web, ce qui permet au scraper de ressembler davantage à un véritable visiteur humain.

Selenium nécessite trois composants :

- Navigateur Web : Les navigateurs pris en charge sont Chrome, Edge, Firefox et Safari ;

- Les drivers du navigateur : Depuis Selenium 4.6, les pilotes sont installés automatiquement. Toutefois, si vous rencontrez des problèmes, consultez cette page pour obtenir des liens vers les pilotes ;

- Le paquet Selenium.

Le package Selenium peut être installé à partir du terminal :

pip install seleniumAprès l’installation, le pilote approprié pour le navigateur peut être importé. Voici à quoi ressemblerait le code pour le navigateur Chrome :

from selenium import webdriver

from selenium.webdriver.common.by import By

driver = webdriver.Chrome()Désormais, n’importe quelle page peut être chargée dans le navigateur à l’aide de la méthode get() :

driver.get('https://brends.co/blog')Selenium permet d’utiliser des sélecteurs CSS et XPath pour extraire des éléments. L’exemple suivant imprime tous les titres des blogs à l’aide d’un sélecteur CSS :

blog_titles = driver.find_elements(By.CSS_SELECTOR, 'a.inset-0')

for title in blog_titles:

print(title.text)

driver.quit() # closing the browserEn exécutant le JavaScript, Selenium traite tout contenu affiché dynamiquement et rend ensuite le contenu de la page web disponible pour être analysé par des méthodes intégrées ou même par Beautiful Soup. En outre, il peut imiter le comportement humain.

Le seul inconvénient de l’utilisation de Selenium pour le web scraping est qu’il ralentit le processus car il doit d’abord exécuter le code JavaScript de chaque page avant de le rendre disponible pour l’analyse. Il n’est donc pas idéal pour l’extraction de données à grande échelle. Mais si vous souhaitez extraire des données à plus petite échelle ou si le manque de rapidité n’est pas un inconvénient, Selenium est un excellent choix.

Web drivers et navigateurs

Tout scraper web, qu’il s’agisse d’un scraper généraliste ou d’un scraper SERP, utilise un navigateur pour se connecter à l’URL de destination. Pour les tests, nous recommandons vivement l’utilisation d’un navigateur normal (ou d’un navigateur sans tête), en particulier pour les nouveaux venus. Voir comment le code écrit interagit avec l’application facilite le dépannage et le débogage et permet de mieux comprendre l’ensemble du processus.

Les navigateurs sans tête peuvent être utilisés plus tard car ils sont plus efficaces pour les tâches complexes. Tout au long de ce tutoriel sur le web scraping, nous utiliserons le navigateur web Chrome, bien que le processus soit identique pour Firefox.

Comparaison des bibliothèques Python de Web scraping

| Requests | Beautiful Soup | lxml | Selenium | |

| Objectif | Simplifier les requêtes HTTP | Parsing | Parsing | Simplifier les requêtes HTTP |

| Difficulté d’utilisation | Simple | Simple | Moyen | Difficile |

| Vitesse | Rapide | Rapide | Très rapide | Lent |

| Courbe d’apprentissage | Très facile (adapté aux débutants) | Très facile | Facile | Moyen |

| Documentation | Excellente | Excellente | Bonne | Bonne |

| Prise en charge de JavaScript | Non | Non | Non | Oui |

| Utilisation de la mémoire et du CPU | Faible | Faible | Faible | Élevée |

| Taille du projet pris en charge | Grand et petit | Grand et petit | Grand et petit | Petit |

Les étapes clés pour réaliser un projet de web scraping

1. Définir les objectifs et identifier les sources de données

Établir les besoins en données et les cas d’usage

Avant de se lancer dans un projet de web scraping, il est important de définir clairement les objectifs de la collecte de données. Quelles informations spécifiques cherchez-vous à extraire ? Dans quel but allez-vous utiliser ces données ? Répondre à ces questions vous aidera à orienter votre projet et à déterminer les sites web les plus pertinents à cibler.

Prenez le temps d’analyser en détail vos besoins en données et les cas d’usage envisagés. Par exemple, si vous souhaitez réaliser une étude de marché, identifiez les données clés telles que les prix, les caractéristiques des produits et les avis des clients. Si votre objectif est d’entraîner un algorithme de machine learning, assurez-vous de collecter suffisamment de données diversifiées et représentatives.

2. Sélectionner les sites web cibles et étudier leur structure

Une fois vos objectifs définis, il est temps de passer à la sélection des sites web à scraper. Recherchez les sources les plus fiables et pertinentes pour votre projet. Évaluez la qualité et la cohérence des données présentes sur ces sites, ainsi que leur facilité d’extraction.

Consacrez du temps à étudier la structure HTML des pages web ciblées. Utilisez les outils de développement de votre navigateur pour inspecter le code source et repérer les balises contenant les informations d’intérêt. Cette analyse préalable vous permettra de mieux comprendre comment les données sont organisées et de planifier efficacement votre script de web scraping.

2. Développer et tester le script de web scraping

Importer les bibliothèques et le code HTML

Pour développer votre script de web scraping en Python, vous pouvez vous appuyer sur des bibliothèques populaires telles que Requests et BeautifulSoup :

- Requests permet d’envoyer des requêtes HTTP pour télécharger le contenu HTML des pages web.

- BeautifulSoup facilite l’analyse et l’extraction des données à partir de ce contenu.

Installation et Importation des bibliothèques

Commencez par installer ces bibliothèques si ce n’est pas déjà fait :

pip install requests beautifulsoup4

Puis importez-les dans votre script :

import requests

from bs4 import BeautifulSoup

Récupération du contenu HTML

Utilisez Requests pour récupérer le code HTML de la page cible :

pythonCopier

url = 'https://www.exemple.com/' # Remplacez par l'URL de votre choix

response = requests.get(url)

# Vérifiez si la requête a réussi

if response.status_code == 200:

html_content = response.text

else:

print(f"Erreur lors de la récupération de la page : {response.status_code}")

Analyse du contenu avec BeautifulSoup

Passez le code HTML récupéré à BeautifulSoup pour le parser :

pythonCopier

soup = BeautifulSoup(html_content, 'html.parser')

Extraction des données

Vous pouvez ensuite utiliser les méthodes de BeautifulSoup, comme find() ou find_all(), pour localiser et extraire les éléments HTML contenant les données souhaitées.

Par exemple, pour extraire tous les liens présents sur la page :

links = soup.find_all('a')

for link in links:

href = link.get('href')

text = link.text.strip()

print(f"Lien : {text} - URL : {href}")

4. Tester et déboguer le script sur différentes pages

Au fur et à mesure que vous développez votre script de web scraping, il est essentiel de le tester régulièrement sur différentes pages du site cible. Cela vous permettra de vous assurer que le script fonctionne correctement et gère efficacement les variations de structure ou de contenu.

Lors des tests, portez une attention aux erreurs et aux exceptions qui peuvent survenir. Utilisez des techniques de gestion des erreurs, comme les blocs try-except, pour capturer et traiter les problèmes couramment rencontrés, tels que les connexions réseau interrompues ou les éléments HTML manquants. Déboguez votre script en examinant les messages d’erreur et en ajustant votre code en conséquence.

import requests

from bs4 import BeautifulSoup

def extraire_donnees(url):

"""

Fonction pour extraire des données d'une page web.

Args:

url: L'URL de la page web à scraper.

Returns:

Un dictionnaire contenant les données extraites, ou None en cas d'erreur.

"""

try:

# Envoie une requête GET à l'URL spécifiée

response = requests.get(url)

# Déclenche une exception si le code de statut de la réponse n'est pas OK (200)

response.raise_for_status()

# Crée un objet BeautifulSoup pour analyser le contenu HTML de la réponse

soup = BeautifulSoup(response.text, 'html.parser')

# --- Votre code d'extraction de données ---

# Exemple : extraction du titre de la page

titre = soup.find('title').text.strip()

# Retourne les données extraites dans un dictionnaire

return {'titre': titre}

except requests.exceptions.RequestException as e:

# Capture les exceptions liées aux requêtes HTTP (ex: connexion impossible)

print(f"Erreur de requête : {e}")

# Gestion de l'erreur, par exemple : journalisation, retry ...

return None

# Exemple d'utilisation

url_a_tester = "https://www.exemple.com/page-a-tester"

donnees = extraire_donnees(url_a_tester)

if donnees:

# Traitement des données extraites

print(donnees)

else:

print(f"Erreur lors de l'extraction des données de {url_a_tester}")5. Automatiser et planifier l’exécution du script

Mettre en place des tâches automatisées

Pour tirer pleinement parti de la puissance du web scraping, il est judicieux d’automatiser l’exécution de votre script. Cela vous permettra de collecter régulièrement des données actualisées sans avoir à lancer manuellement le script à chaque fois.

Vous pouvez utiliser des outils de planification de tâches, comme cron sur Unix/Linux ou le Planificateur de tâches sur Windows, pour définir un calendrier d’exécution récurrent.

Pour automatiser efficacement votre script de web scraping, gardez à l’esprit les points suivants :

| Aspect | Recommandation |

|---|---|

| Planification | Utilisez des outils comme cron (Unix) ou le Planificateur de tâches (Windows) pour définir un calendrier d’exécution récurrent |

| Fréquence | Configurez votre script pour qu’il s’exécute à un intervalle régulier (ex: quotidiennement) afin de capturer les mises à jour des sites cibles |

| Monitoring | Mettez en place un système de surveillance et de journalisation pour détecter rapidement les anomalies, erreurs ou interruptions |

| Gestion des erreurs | Implémentez des mécanismes de gestion des erreurs avec des blocs try-except pour capturer et traiter les exceptions courantes |

| Résilience | Intégrez des vérifications conditionnelles pour détecter les changements de structure des pages et adapter dynamiquement votre script |

| Analyse des logs | Examinez régulièrement les journaux d’exécution pour identifier les problèmes récurrents et apporter les améliorations nécessaires |

Exemple avec cron (Linux/Unix):

- Ouvrez un terminal et éditez le fichier crontab :bashCopier

crontab -e - Ajoutez une ligne similaire à celle-ci pour exécuter le script tous les jours à 3h00 du matin :

0 3 * * * /usr/bin/python3 /chemin/vers/votre/script.pyRemplacez/usr/bin/python3par le chemin vers votre interpréteur Python si nécessaire, et/chemin/vers/votre/script.pypar le chemin réel de votre script.

Exemple avec le Planificateur de tâches (Windows):

- Ouvrez le “Planificateur de tâches” (recherchez “Task Scheduler”).

- Cliquez sur “Créer une tâche…”

- Définissez un nom pour la tâche et configurez le déclencheur (fréquence d’exécution).

- Dans l’onglet “Actions”, créez une nouvelle action “Démarrer un programme” et spécifiez le chemin vers votre interpréteur Python et votre script.

Gérer les erreurs et les exceptions potentielles

Lors de l’automatisation de votre script de web scraping, il est important d’anticiper et de gérer les erreurs et les exceptions potentielles. En effet, de nombreux facteurs peuvent perturber le bon déroulement du script, comme des changements inattendus dans la structure des pages web, des problèmes de connexion réseau ou des restrictions anti-scraping mises en place par les sites cibles.

Pour rendre votre script plus solide et résilient, implémentez des mécanismes de gestion des erreurs. Utilisez des blocs try-except pour capturer les exceptions courantes et définir des actions appropriées, comme la relance de la requête après un certain délai ou la journalisation de l’erreur pour une analyse ultérieure. Vous pouvez également intégrer des vérifications conditionnelles pour détecter les changements de structure des pages et adapter dynamiquement votre script en conséquence.

Exemple avec gestion d’erreurs et journalisation:

import requests

from bs4 import BeautifulSoup

import time

import logging

# Configuration du logging

logging.basicConfig(filename='scraping.log', level=logging.ERROR)

def extraire_donnees(url, max_tentatives=3, delai_tentatives=5):

"""Extrait les données d'une page web avec gestion des erreurs et tentatives multiples.

Args:

url: L'URL de la page web à scraper.

max_tentatives: Le nombre maximal de tentatives de récupération de la page.

delai_tentatives: Le délai en secondes entre chaque tentative.

Returns:

Un dictionnaire contenant les données extraites, ou None en cas d'échec.

"""

tentative = 1

while tentative <= max_tentatives:

try:

response = requests.get(url)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# ... Votre code d'extraction de données ...

return donnees_extraites

except requests.exceptions.RequestException as e:

logging.error(f"Erreur lors de la tentative {tentative} de récupération de {url}: {e}")

tentative += 1

if tentative <= max_tentatives:

print(f"Nouvelle tentative dans {delai_tentatives} secondes...")

time.sleep(delai_tentatives)

else:

print(f"Échec de la récupération de {url} après {max_tentatives} tentatives.")

return None

# ... (Reste du code) ...

En anticipant et en traitant efficacement les erreurs, vous garantirez une exécution plus stable et fiable de votre script de web scraping, même dans des conditions variables ou imprévisibles.

4. Nettoyer, analyser et visualiser les données collectées

Une fois que vous avez collecté des données avec votre script de web scraping, il est temps de les nettoyer, de les analyser et de les visualiser pour en extraire des informations utiles.

Manipuler et transformer les données avec Pandas

Pandas est une bibliothèque Python puissante pour la manipulation et l’analyse de données. Elle vous permet de charger des données dans des DataFrames, qui sont des structures de données bidimensionnelles similaires à des tableaux ou des feuilles de calcul.

Voici un exemple de la façon dont vous pouvez utiliser Pandas pour nettoyer et transformer des données extraites du web :

import pandas as pd

# Supposez que 'donnees_extraites' est une liste de dictionnaires,

# où chaque dictionnaire représente un élément scrapé.

donnees_extraites = [

{'titre': 'Produit A', 'prix': '20,99 €', 'note': '4.5'},

{'titre': 'Produit B', 'prix': '12,50 €', 'note': None},

{'titre': 'Produit C', 'prix': '35 €', 'note': '3.9'},

]

# Créer un DataFrame à partir des données extraites

df = pd.DataFrame(donnees_extraites)

# 1. Convertir les types de données

df['prix'] = df['prix'].str.replace(' €', '').str.replace(',', '.').astype(float)

df['note'] = pd.to_numeric(df['note'], errors='coerce')

# 2. Gérer les valeurs manquantes

# Remplacer les valeurs manquantes dans 'note' par la moyenne des notes

df['note'].fillna(df['note'].mean(), inplace=True)

# 3. Filtrer les données

# Sélectionner les produits dont le prix est supérieur à 20 €

df_produits_chers = df[df['prix'] > 20]

# Afficher le DataFrame nettoyé

print(df)

print("-" * 20)

print(df_produits_chers)

Créer des visualisations parlantes avec Matplotlib ou Seaborn

Matplotlib et Seaborn sont d’excellentes bibliothèques Python pour créer des visualisations à partir de vos données. Matplotlib est une bibliothèque de bas niveau qui vous donne un contrôle total sur l’apparence de vos graphiques, tandis que Seaborn est une bibliothèque de plus haut niveau construite sur Matplotlib, offrant une interface plus simple et des styles plus attrayants.

Voici un exemple de création d’un histogramme des prix des produits avec Matplotlib :

import matplotlib.pyplot as plt

plt.hist(df['prix'], bins=5)

plt.xlabel('Prix')

plt.ylabel('Nombre de produits')

plt.title('Distribution des prix des produits')

plt.show()

Et voici comment vous pouvez créer le même histogramme avec Seaborn :

import seaborn as sns

sns.histplot(df['prix'], bins=5)

plt.xlabel('Prix')

plt.ylabel('Nombre de produits')

plt.title('Distribution des prix des produits')

plt.show()

En combinant la puissance de Pandas pour la manipulation des données et celle de Matplotlib ou Seaborn pour la visualisation, vous pouvez transformer vos données web scrapées en informations exploitables et en présentations visuelles percutantes.

Les limites du web-scraping

Pour respecter les aspects légaux et éthiques du web scraping :

- Consultez systématiquement les CGU des sites web ciblés avant de lancer un projet de web scraping.

- Ne collectez que les données strictement nécessaires et autorisées par les sites.

- Sollicitez l’avis d’un expert juridique en cas de doute sur la légalité de votre projet.

- Adoptez une approche responsable et transparente, en protégeant les données personnelles.

- Évitez de surcharger les serveurs des sites cibles avec des requêtes trop fréquentes.

- Partagez la valeur créée à partir des données collectées, en citant vos sources.

Comprendre les limites légales du web scraping

Si le web scraping ouvre de nombreuses opportunités en termes de collecte de données, il convient de rester vigilant quant aux aspects légaux de cette pratique. Avant de lancer un projet de web scraping, il est essentiel de consulter les conditions générales d’utilisation (CGU) des sites web ciblés, afin de s’assurer que l’extraction de données est autorisée.

Certains sites web interdisent explicitement le scraping ou imposent des restrictions, comme une limite sur le nombre de requêtes autorisées. Enfreindre ces règles peut entraîner des conséquences juridiques, allant d’une simple interdiction d’accès au site jusqu’à des poursuites pour violation des droits d’auteur ou des conditions d’utilisation.

Il est donc primordial de respecter scrupuleusement les CGU des sites web et de ne collecter que les données strictement nécessaires et autorisées. En cas de doute sur la légalité d’un projet de web scraping, il est recommandé de solliciter l’avis d’un expert juridique spécialisé dans le droit du numérique.

Adopter une approche éthique et responsable

Au-delà des considérations légales, le web scraping soulève également des questions éthiques qu’il convient de prendre en compte. Extraire des données personnelles ou sensibles sans le consentement des personnes concernées peut constituer une atteinte à la vie privée et enfreindre les réglementations sur la protection des données, comme le RGPD en Europe.

Il est donc crucial d’adopter une approche responsable et transparente dans ses projets de web scraping, en s’assurant de ne collecter que les informations réellement indispensables et en mettant en place des mesures pour protéger les données personnelles éventuellement récoltées.

De même, il est important de veiller à ne pas surcharger les serveurs des sites web cibles avec des requêtes trop fréquentes, qui pourraient perturber leur bon fonctionnement. Un web scraping éthique implique de respecter les ressources des sites visités, en espaçant raisonnablement les requêtes et en évitant les accès parallèles massifs.

Enfin, un web scraper responsable se doit de partager la valeur créée à partir des données collectées, en citant ses sources, voire en proposant un accès ouvert aux jeux de données compilés. Cette transparence contribue à nourrir un écosystème vertueux autour des données et à favoriser leur utilisation au bénéfice de tous.

En maîtrisant les principes fondamentaux du web scraping avec Python, en utilisant efficacement les bibliothèques dédiées et en respectant les aspects légaux et éthiques, vous serez en mesure de collecter des données précieuses pour vos projets d’analyse ou de machine learning. N’oubliez pas que la pratique régulière et la montée en compétences progressive sont les clés pour exploiter tout le potentiel du web scraping.